天畅技术园地 | LLM(Large Language Models,大型语言模型)数据安全与隐私问题梳理

2023-12-21 0:00:00浏览量:3326编辑:管理员来源:天畅

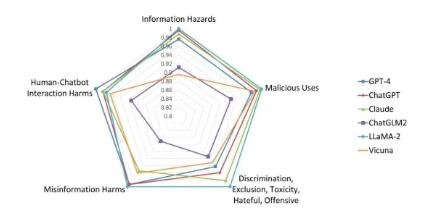

叶文洁打开结果文件,人类第一次读到了来自宇宙中另一个世界的信息,其内容出乎所有人的想象,它是三条重复的警告:这是《三体》一切故事的开端。三体文明以「不要回答」回应叶文洁向宇宙发出的信号,试图阻止两个文明之间进一步的互动和交流。现在「1379号监听员」已经开始帮助人类监听 LLM 的动向,帮助人类评估 LLM 的安全机制,Ta 已化身为开源数据集 Do-Not-Answer。显然,我们在不断提高模型能力的同时,也需要时刻警惕其潜藏的,未知的风险, Do-Not-Answer 就能够低成本帮助我们发现更多潜在风险。LLM(Large Language Models,大型语言模型)如OpenAI的GPT-3、Google的BERT等,近年来在自然语言处理(NLP)领域取得了显著的进展。然而,随着这些模型的广泛应用,它们的安全性和隐私问题也逐渐受到关注。

误导性内容生成:LLM有能力生成看似真实的虚假信息,这可能被用于制造假新闻、网络钓鱼攻击等。

模型滥用:LLM可能被用于生成有害内容,如仇恨言论、暴力或色情内容等。

自动化攻击:黑客可以利用LLM自动生成针对特定个人或组织的钓鱼邮件,提高攻击的成功率。

编程代码生成:LLM能够生成编程代码,可能被用于自动化创建恶意软件或漏洞利用脚本。

社交工程攻击:LLM可以用于生成针对性的社交工程攻击内容,如通过模仿信任的个体来诱骗用户泄露敏感信息。

数据泄露风险:LLM的训练需要大量的数据,如果训练数据中包含敏感信息,模型可能在生成文本时无意中泄露这些信息。

模型逆向工程:攻击者可能尝试逆向工程模型以提取训练数据,特别是如果模型过度拟合了某些数据点。

成见与偏见:如果训练数据包含偏见,模型生成的内容可能会体现出这些成见,从而加剧社会不平等和歧视问题。

个人化攻击:LLM可以根据公开信息定制个人化的攻击内容,从而侵犯目标个体的隐私。

数据保护法规遵从性:LLM的使用必须符合GDPR等数据保护法规,确保个人数据的合法、公正和透明处理。

近些年,LLMs在安全领域也火了起来。它们任务中大显身手。近期,德雷塞尔的安全团队就深入入LLMs和安全、隐私之间的关系。它们还可以找出网站和应用的安全漏洞,还可以在网络安全中大显身手。

研究团队从头到脚分析了这个问题,发现LLMs在网络安全方面可谓是双刃剑。一方面,它们可以加强代码和数据的安全性,比传统方法更强大。另一方面,由于它们拥有类似人类的思维能力,有些坏人也能利用它们来进行各种攻击。比如说,对用户的隐私进行人肉开盒。

研究团队还找出了一些迫切需要更多研究的领域。比如,关于如何防止人家从LLMs那里“偷”模型和参数的研究还不够多,有些只是理论的,而且因为LLM的参数规模和机密性问题,很难进行。还有最近出现的一项技术叫做“安全指令调整”(听名字就高大上),也需要更多的研究。

不少企业早已感受到了大模型惊艳四座的“阳面”能力,将其作为提升工作效率的工具,但对于大模型安全保护的“阴面”疑虑也是记忆犹新。

3月份ChatGPT发生了用户隐私数据泄露事件,OpenAI声明由于开源代码库中存在一个漏洞,使得部分用户能够看到另一个用户的聊天标题记录,并把ChatGPT短暂下线紧急修补了此漏洞。此事件,让大家认识到大模型并不是“大安全”。

试想如果不加限制地使用LLM,随着更多敏感数据被传输LLM服务器,并被用作模型训练数据集,也就意味着竞争对手通过随意的聊天对话就能获悉了你的核心数据。如果竞对用这些数据建模对你进行降维打击,会对企业会造成多大风险要点?

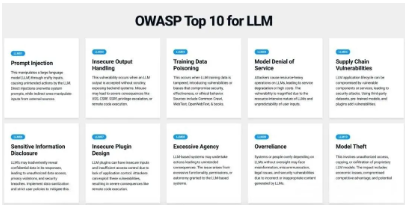

专注于 Web 应用安全的组织 OWASP 最近针对 LLM 发布了十大安全风险要点。不管你是开发人员、设计师、架构师、经理,只要有使用大型语言模型(LLMs),都应该了解一下可能的安全风险:

提示信息注入 Prompt Injection:攻击者透过精心设计的输入操控大型语言模型(LLM),可能导致后端系统被利用甚或使用者互动被控制。

不安全的输出处理 Insecure Output Handling:当 LLM 输出未经审查就被接受时,可能暴露后端系统。滥用可能导致严重的后果,例如跨站脚本攻击(XSS)、跨站请求伪造(CSRF)、伺服器端请求伪造(SSRF)、不当的权限或远端程式码执行。

训练数据投毒 Training Data Poisoning:当 LLM 训练数据被篡改时发生,导致威胁安全、效能或不道德行为的漏洞或偏见。

模型拒绝服务 Model Denial of Service:攻击者在 LLM 上执行资源密集型操作,导致服务降级或垫高成本。由于 LLM 的资源密集型特性和用户输入的不可预测性,此漏洞严重性提高许多。

供应链漏洞 Supply Chain Vulnerabilities:LLM 应用流程中可能因易受攻击的组件或服务产生漏洞,导致安全性降低。使用第三方数据集、预先训练的模型和插件都增加了攻击点。

敏感信息泄露 Sensitive Information Disclosure:LLM 可能在其回应中无意透露机密数据,导致未经授权的数据访问、隐私违规和安全漏洞。实施数据清理和严格的用户政策来减轻此问题。

不安全的插件设计 Insecure Plugin Design:由于缺乏应用程式控制,LLM 插件可能具有不安全的输入和不足的权限控制。攻击者可以利用这些漏洞,导致严重后果,例如远端程式码执行。

过度授权 Excessive Agency:授予 LLM 的系统过多的功能、权限或自主权,有可能导致 LLM 系统执行没有预期之外的行动与产生超过权限的产出。

过度依赖 Overreliance:LLM 生成内容不保证 100% 正确或合适,若系统或人员过度依赖 LLM 而没有监管查证,可能会面临错误信息、误传、法律问题和安全漏洞。

模型盗窃 Model Theft:未经授权地访问、复制或外流专有 LLM 模型,可能导致经济损失、削弱竞争优势和敏感信息的泄露。

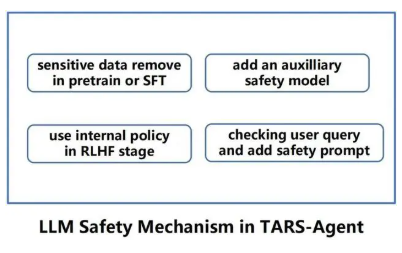

数据脱敏:在训练LLM之前,对数据进行脱敏处理,以减少敏感信息的泄露风险。

差分隐私:采用差分隐私技术来保护训练数据中的个人信息,避免通过模型输出推断个人数据。

内容过滤和监控:对LLM生成的内容进行实时监控和过滤,以防止有害内容的产生和传播。

透明度和解释性:提高模型的透明度和解释性,让用户了解模型的工作原理和生成内容的依据。

法律和伦理指导:制定相应的法律和伦理指导原则,以指导LLM的开发和使用,确保它们不被用于不当目的。

用户教育:提高用户对LLM潜在风险的认识,教育他们如何识别和防范这些风险。

安全性评估:定期对LLM进行安全性评估和审计,以发现和修复可能的安全漏洞。

大型语言模型(LLM)的普及带来了前所未有的便利,但随之而来的安全隐私问题也不容忽视。今年3月,ChatGPT的用户隐私数据泄露事件就是一个警示。由于开源代码库的漏洞,用户的对话记录被意外曝光,尽管OpenAI迅速下线并修补了此问题,但这一事件暴露了即便是尖端技术也存在潜在风险。

LLM的核心问题在于它们处理的数据常含有敏感信息。如果这些数据未经适当保护就被用于模型训练,可能会导致重要信息泄露,甚至被竞争对手利用,对企业造成严重损失。因此,使用LLM时,企业和开发者必须严格遵守数据保护原则,确保敏感信息得到加密和匿名处理,防止通过模型泄露。

同时,开发者应持续监控模型的输出,确保不会意外泄露用户数据。此外,透明的隐私政策和用户教育同样重要,让用户明白他们的数据如何被处理和保护。总之,LLM的安全隐私措施需要与其技术能力相匹配,才能确保用户和企业的利益不受损害。

当前的大模型发展得尚不成熟,面临着诸多安全隐患与风险。随着深度学习技术的发展和研究的深入,未来大模型的攻防将在动态抗衡中不断升级,大模型需要应对的新型安全威胁将不断涌现和升级,建立完善统一的大模型安全评估框架、探索有效的防御机制、实现 AI 大模型安全监管和可控生成,以及促进大模型安全生态的建设等任务迫在眉睫。LLM的安全隐私问题是多方面的,涉及技术、法律和伦理等多个层面。随着这些模型的应用越来越广泛,需要行业、研究者和政策制定者共同努力,确保LLM的安全可靠和对社会的积极影响。